歡迎來(lái)到沁陽(yáng)市科瑞實(shí)業(yè)有限公司官方網(wǎng)站!

設為首頁(yè)?。?a href="javascript:void(0)" onclick="shoucang(document.title,window.location)">收藏本站?。?a href="/contact">聯(lián)系我們

產(chǎn)品列表

公司簡(jiǎn)介

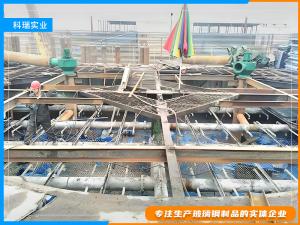

沁陽(yáng)市科瑞實(shí)業(yè)有限公司,位于河南省北部美麗的太行山腳下,華北平原的邊緣,境內有豐富的古文化和旅游資源,國家景區神農山以其雄、險、奇、秀的美譽(yù)笑迎中外游客,人杰地靈。交通運輸四通八達?! ∥夜臼遣Aт撝破返膶?shí)體企業(yè)?! ∥夜疽钥萍紴橄葘?,不斷進(jìn)行技術(shù)創(chuàng )新,努力開(kāi)發(fā)研制市場(chǎng)需求,客戶(hù)滿(mǎn)意的新產(chǎn)品。主要生產(chǎn)產(chǎn)品有:玻璃鋼大口徑蝶閥、玻璃鋼拉擠型材、玻璃鋼格柵、玻璃鋼...[了解詳細]

- 玻璃鋼的性能[2021-03-15]

- 玻璃鋼材料的原理[2021-03-15]

- 什么是玻璃鋼[2021-03-15]

- 玻璃鋼制品的用途[2021-03-15]

- 玻璃鋼制品的生產(chǎn)過(guò)程[2021-03-15]

- 玻璃鋼制品的特點(diǎn)[2021-03-15]

聯(lián)系我們

- 沁陽(yáng)市科瑞實(shí)業(yè)有限公司

- 聯(lián)系人:呂總

- 13462425111

- 地 址:沁陽(yáng)市紫陵鎮工業(yè)區

- 郵 箱:13462425111@126.com